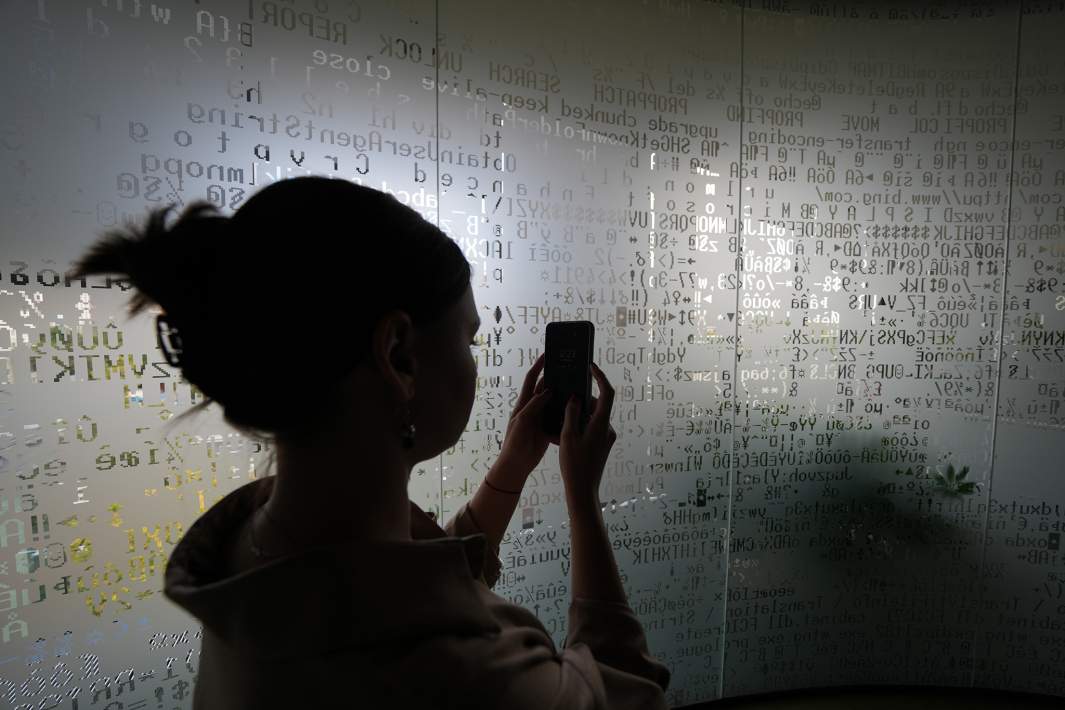

Лицевой расчет: в январе россиян 2 тыс. раз атаковали с помощью дипфейков

В январе мошенники провели более 2 тыс. атак на россиян с помощью дипфейков, оценили для «Известий» в RTM Group. В исследовании компании говорится, что порядка 70% обманов нацелены на граждан: для выманивания денег генерируются голоса родных и знакомых. Остальные направлены против должностных лиц в компаниях или госорганах, оттуда могут украсть данные или средства. В крупнейших банках видят риски в развитии новой технологии обмана. Но защититься от нее можно уже имеющимися методами: приостановкой подозрительных операций и повышением финансовой грамотности.

Как россиян обманывают с помощью дипфейков

В первый месяц 2024 года число атак на россиян с помощью дипфейков подскочило, сообщили «Известиям» в RTM Group. По оценкам компании, за январь на территории РФ их было более 2 тыс. Первые попытки обманывать людей таким способом были еще в конце 2022-го, отметили в компании. Тогда мошенники делали рассылки вредоносного кода и фишинговых сообщений, сгенерированных посредством ChatGPT.

— Если раньше все ограничивалось придуманной текстовой информацией, то теперь злоумышленники пошли еще дальше — в открытый доступ в 2023 году попали алгоритмы, способные осуществлять подмену голоса практически в реальном времени, — предупредил руководитель направления кибербезопасности RTM Group Артем Бруданин.

Например, существует сервис, который позволяет загрузить в него звуковой файл с голосом человека, автоматически его обработать. На выходе получается файл с тем же голосом, но произносящий любой текст, пояснили в RTM Group. Достигается это за счет клонирования параметров исходного файла. Чтобы обучить систему, злоумышленники загружают туда голосовые файлы из открытых источников.

Более 70% выявленных атак с помощью дипфейков направлены на физических лиц с целью кражи денег, отмечается в исследовании. Там пояснили: злоумышленники подделывают голоса и совершают звонки от имени сына, дочери или пожилого родственника жертвы, а также от имени его друзей или коллег.

— Именно в этой среде — в семье, между знакомыми, коллегами — принято обмениваться голосовыми сообщениями и выкладывать их в общей доступ: в социальные сети, мессенджеры, — пояснил Артем Бруданин.

Для людей существует и еще одна угроза дипфейков — потеря репутации, добавил эксперт сервиса аналитики и оценки цифровых угроз ГК Softline Максим Грязев. Он напомнил, что в прошлом году резонанс получила история с российской стримершей, лицо которой неизвестные наложили на видео с маркировкой 18+.

Еще около 20% атак были направлены на сотрудников коммерческих организаций с целью кражи конфиденциальных данных, отмечается в исследовании RTM Group. Оставшиеся 10% обманов нацелены против сотрудников госорганов, а их целью была кража средств организации или информации оттуда.

Известны инциденты, в которых злоумышленники притворялись директорами крупных компаний и убеждали сотрудников перевести средства на свой счет, рассказал старший исследователь данных в «Лаборатории Касперского» Дмитрий Аникин.

— С точки зрения визуальных дипфейков известен сценарий, при котором поддельные видео со знаменитостями используют в «продвижении» ненастоящих инвестиционных проектов. В таких видео известное лицо может якобы давать финансовые рекомендации и убеждать пользователей вкладывать свои деньги в тот или иной проект, который на самом деле принадлежит мошенникам, — добавил он.

Как защититься от мошенничеств с помощью дипфейков

Злоумышленники стали активно использовать новые технологии, говорил на форуме ЦБ по кибербезопасности зампред правления ВТБ Вадим Кулик. По его словам, зафиксированы первые случаи, когда мошенники применяли записи голоса, чтобы подменить биометрию клиентов, сгенерировав разговор от их лица. Также преступники используют дипфейки.

— Уже есть кейсы, когда видеоконсультация банков приводила к тому, что деньги уплыли. К этому виду фрода мы пока не готовы от слова совсем. Здесь нужно будет создавать серию новых процессов и новых технологий. Пока, к сожалению, успешность была 100 из 100, — рассказал Вадим Кулик.

В ВТБ пояснили «Известиям», что чаще всего в банке сталкиваются с обманом клиентов при помощи методов социальной инженерии с применением дипфейков. В таком случае при звонке или видеозвонке пользователь видит сгенерированное нейросетью изображение или слышит смоделированный голос собеседника.

— Причем обычно дипфейк используется не для имитации реальных знакомых атакуемого пользователя, а для сокрытия лица реального преступника, чтобы невозможно было установить его личность и задокументировать следы преступления. Иногда могут использоваться изображения известных актеров или политиков, — пояснили в ВТБ.

«Известия» направили запросы в другие крупные кредитные организации о том, сталкивались ли там с мошенничеством с использованием дипфейков. В МТС Банке и «Зените» сказали, что не фиксировали таких инцидентов. В Росбанке о схеме знают, но не видят всплеска в ее применении.

В финансовых организациях сказали, что защищать клиентов от обмана с использованием новой технологии можно все теми же методами, что и с предшествующими схемами. Например, в ВТБ реагируют на нетипичное поведение пользователя — когда он внезапно решил перевести крупную сумму на неиспользуемый им ранее счет или же взять большой кредит. Тогда можно приостановить эту операцию и провести разъяснительную работу с клиентом.

Подозрительные транзакции отслеживаются с помощью антифрод-системы банка, добавили в «Зените». В МТС Банке уточнили, что также используют средства выявления дипфейков в системах проверки биометрии.

Как считают опрошенные «Известиями» эксперты, в дальнейшем вектор атак с помощью дипфейков будет только развиваться. По-прежнему важный элемент их сдерживания — повышение финансовой грамотности, то есть информирование клиентов о наиболее популярных схемах мошенничества, включая схемы с использованием искусственного интеллекта и дипфейков, резюмировали в Росбанке.